In den vergangenen Jahren haben wir eine Menge Data Science-Erfahrung in unterschiedlichsten Projekten und Use Cases gesammelt. Jetzt ist es an der Zeit, diese Insights mit euch (BITTE MAL CHECKEN OB DUZEN ODER SIEZEN…) zu teilen. Dafür starten wir eine ganze Beitragsreihe, in der wir anhand spannender Themen zeigen, wie Data Science Methoden relevante Insights im E-Commerce liefern und neue Erkenntnisse bringen. Los geht’s!

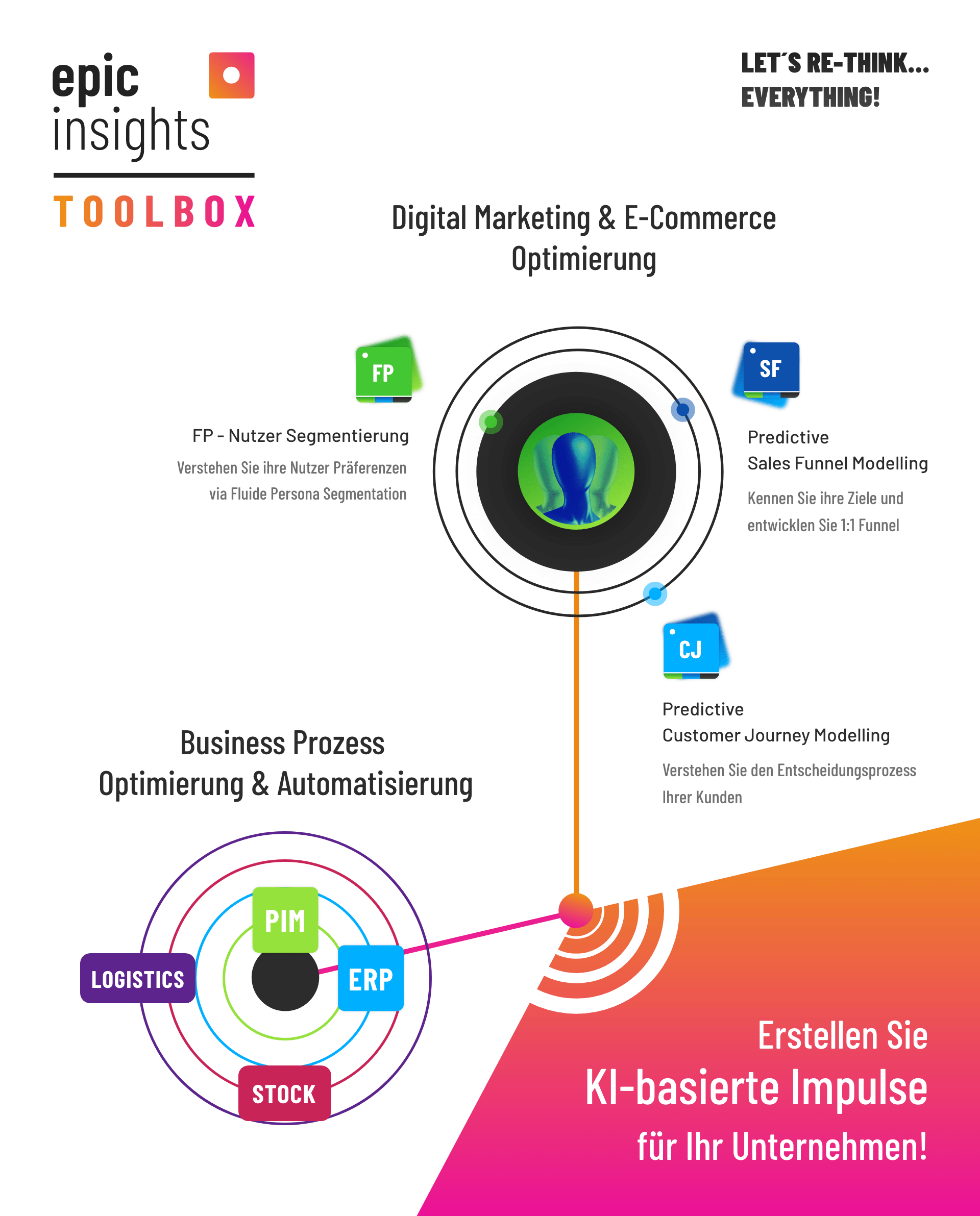

Im Bereich der User-Verhaltensanalyse auf Websites und Online-Shops bieten wir unseren Kunden seit 2016 tiefergehende datengestützte Analysen und individuelle Personalisierungslösungen. Als Grundlage haben wir dafür unsere epicinsights Toolbox entwickelt, über die wir sowohl individuell zugeschnittene Software-Lösungen als auch individuelle Beratungsleistungen für unsere Kunden bieten.

Auf der Frontend-Seite haben wir hierfür die KI-basierten Fluiden Personas und User Journey-Analysen, die sich bereits in den verschiedensten Use Cases im E-Commerce beweisen konnten. Seit 2020 haben wir das Leistungsspektrum auf den Backend- bzw. Backoffice-Bereich erweitert und liefern konfektionierbare KI-basierte Solutions auch für das gesamte Datenmanagement im E-Commerce Fullfillment und Logistik-Bereich. Hier gibt es Kalkulations- und Forecasting-Lösungen von PIM über ERP bis hin zu Lieferprozessen im Bereich Supply Chain Management.

Anhand konkreter Use Cases wollen wir in dieser Beitragsreihe gemeinsam mit Ihnen (BITTE MAL CHECKEN OB DUZEN ODER SIEZEN…) eine neue Perspektive einnehmen. Dafür erweitern wir unseren Fokus über die Nutzer und ihr individuelles Verhalten hinaus auf die angebotenen Produkte und Shop-Management-Prozesse. Welche Produkte sind die beliebtesten und sollten immer vorrätig sein? Was wird häufig zusammen gekauft? Zu welchen Zeiten und Wochentagen kaufen die meisten Kunden ein? Wie kann ich Bestellungen meiner Lieferanten forecasten und was gilt es dabei zu beachten? Wie kann ich Out-of-Stock Situationen vermeiden?

Wie wir für die Beantwortung dieser Fragen vorgegangen sind und welchen Herausforderungen wir dabei gegenüber standen, werden wir in dieser Beitragsreihe detailliert beleuchten. Die konkreten Anwendungsfälle reichen dabei von den Branchen Automotive über Fashion und Beauty bis hin zu Wohntextilien. Vor allem für E-Commerce Manager und Digital Marketers ergeben sich hieraus spannende neue Erkenntnisse über ihre Produkte und Kunden, die echten Wettbewerbsvorteil liefern. Klingt gut? Dann bleiben Sie /DU ??? dran, Fortsetzung folgt.

In der Welt der künstlichen Intelligenz (KI) sind Embeddings die unsichtbaren Pfade, auf denen die Fähigkeit zur semantischen Interpretation und Informationsverarbeitung von Sprachmodellen wie Large Language Models (LLMs) beruht. Der Schein von Klugheit, die Illusion von Intelligenz basiert auf hochdimensionalen Vektorräumen, die das Herzstück einer tiefgreifenden Sprachverarbeitung sind und es ermöglichen, Maschinen und Texte besser zu verstehen, Beziehungen zwischen Wörtern herzustellen und semantische Kontexte zu erfassen.

Tauchen wir tiefer in diese faszinierende Komponente ein und enthüllen die Magie hinter den unscheinbaren, aber kraftvollen Vektoren.

Im Zentrum jedes LLMs liegen Embeddings – eine Art magische Landkarte, die den Maschinen ermöglicht, die Bedeutung von Wörtern und Texten zu verstehen. Word Embeddings sind Schlüsselelemente, die sich auf einzelne Wörter und ihre Bedeutung konzentrieren. Sie schaffen Beziehungen zwischen Wörtern im Vektorraum und ermöglichen es der KI, semantische Zusammenhänge zu erfassen oder Wortübersetzungen durchzuführen.

Doch Embeddings sind mehr als nur einzelne Wörter. Dokument Embeddings erfassen den Gesamtzusammenhang, die Struktur und das Thema eines gesamten Textes oder einer Passage. Sie ermöglichen es, ähnliche Texte im Vektorraum nahe beieinander zu positionieren, unabhängig von der Sprache oder den verwendeten Worten.

Die wahre Schönheit dieser Embeddings liegt in ihrer Fähigkeit, Information abstrakt darzustellen. Sie nehmen jeden Aspekt eines Textes und transformieren ihn in mathematische Vektoren, die für Maschinen verständlich sind. Der Abstand zwischen zwei Vektoren (Siehe Grafik) misst ihre Verwandtschaft. Kleine Entfernungen deuten auf eine hohe Verwandtschaft hin, große Entfernungen auf eine geringe Verwandtschaft. Dabei sind Embeddings das Geheimnis hinter der erstaunlichen Fähigkeit von LLMs, Texte zu verstehen und entsprechend zu verarbeiten.

Embeddings sind die Grundlage für zahlreiche Anwendungen von LLMs. Sie ermöglichen die Entdeckung semantischer Zusammenhänge, Wortübersetzungen, Textklassifizierung und -analysen über Sprachgrenzen hinweg. Ihre Vielseitigkeit erstreckt sich auch auf multilinguale und multimodale Anwendungen, wo Texte, Bilder, Audio- und Videoinhalte nahtlos verarbeitet werden können. Diese vielfältigen Anwendungen machen Embeddings zu einem zentralen Bestandteil von KI-Projekten. Die fortwährende Entwicklung von LLMs und deren Embeddings eröffnet innovative Möglichkeiten, um Probleme in verschiedenen Bereichen zu lösen, sei es in der Medizin, der Finanzwelt, im Kundenservice oder in der Forschung.

Bei epicinsights sind wir Experten in der Welt der künstlichen Intelligenz und der Implementierung von LLMs in unterschiedlichsten Projekten, wie unserem Podcast Monitoring Tool Podmon. Unsere Fachkenntnisse und Erfahrungen ermöglichen es uns, die Leistungsfähigkeit von Embeddings und LLMs optimal zu nutzen, um maßgeschneiderte Lösungen für die Bedürfnisse unserer Kunden zu schaffen.

Wenn Sie Ihr Unternehmen in die Welt der KI führen möchten, stehen wir Ihnen als Partner zur Seite. Kontaktieren Sie uns noch heute, um mehr über unsere KI-Kompetenzen und Erfahrungen zu erfahren und gemeinsam die Potenziale von LLMs und Embeddings zu entdecken. Lassen Sie uns zusammen die Zukunft gestalten!

In der Welt der Künstlichen Intelligenz führt die Evolution von Large Language Models zu mächtigen Entwicklungen, wie GPT-4, die Speerspitze der menschenähnlichen Texterstellung. Durch die Analyse von gigantischen Textmengen lernen diese Modelle, das Wesen menschlicher Kommunikation nicht nur nachzuahmen, sondern auch vorauszusehen.

Sprachmodelle (Language Modells) sind Algorithmen, die darauf abzielen, die Struktur und Wahrscheinlichkeit von Wort Sequenzen in natürlichen Sprachen für Anwendungen wie Übersetzung oder Textgenerierung zu verstehen und vorherzusagen.

LLMs (Large Language Models) hingegen sind hochleistungsfähige Sprachmodelle, die auf umfangreichen Textdatensätzen trainiert wurden, um komplexe natürliche Sprachverarbeitungsaufgaben zu bewältigen. Der freie Zugang zu LLMs durch Open Source-Projekte entfacht einen unvergleichlichen Innovationsgeist. Entwickler und Forscher auf der ganzen Welt tragen zu einer rapiden Weiterentwicklung der Technologie bei, dessen Grenzen stets neu definiert werden.

Große Sprachmodelle wie die GPT-Modelle setzen neue Maßstäbe in der menschenähnlichen Textproduktion. Ihr Ziel ist es, Antworten zu liefern, die nicht nur plausibel wirken, sondern uns glauben lassen, wir würden mit einem Menschen kommunizieren.

Aber ein kritischer Blick enthüllt eine entscheidende Schwäche: LLMs sind programmiert, um stets eine Antwort zu generieren – unabhängig davon, ob diese richtig oder falsch ist. Das täuscht oft über ihr wahres Wesen hinweg und führt zu der Frage: Handelt es sich hierbei um „echte“ Intelligenz? Die Antwort fällt ernüchternd aus. Denn so überzeugend ihre menschenähnlichen Antworten auch erscheinen mögen, besitzen LLMs nicht das Verständnis, die Vernunft oder das Bewusstsein, die echte menschliche Intelligenz auszeichnen. Sie sind vielmehr raffinierte Nachahmer, die uns einen Spiegel vorhalten – einen Spiegel, der unsere eigene Sprache reflektiert, jedoch ohne das tiefergehende Verstehen dessen, was wirklich gesagt wird.

Auf dem dynamischen Spielfeld der Large Language Models (LLMs) begegnen sich Titanen der Tech-Industrie in einem spannenden Wettstreit. Der Riese OpenAI hat mit Modellen wie GPT-3 die Messlatte hochgelegt, ein Trendsetter, der von Forschungsinstituten bis zu Startups Beachtung findet. Google ist mit seinem eigenen DeepMind AI Lab und der Entwicklung von BERT und anderen Sprachmodellen nicht weit hinten und drängt mit stetigen Innovationen an die Spitze. Facebooks Mutterkonzern Meta mischt ebenfalls kräftig mit und treibt LLM-Forschung mit Projekten wie BART und RoBERTa voran. Microsoft, mit exklusiven Lizenzrechten für die Implementierung von GPT-3 und der Entwicklung eigener AI-Frameworks, ist ein weiterer zentraler Akteur auf diesem Markt. Nehmen wir noch IBM mit Watson und kleinere, aber agile Open-Source-Alternativen dazu, wird klar: Die Landschaft der LLM-Anbieter ist ein Mix aus ambitioniertem Wettbewerb, technologischem Fortschritt und der ständigen Suche nach dem nächsten großen Durchbruch in künstlicher Intelligenz. Dabei spielt Open Source AI aus folgenden Gründen eine wichtige Rolle:

Embeddings, die geheime Zutat der LLMs, führen uns auf einer Karte des Textverständnisses. Sie erfassen den Kern von Wörtern und Dokumenten und ermöglichen eine tiefere Erkenntnis der beabsichtigten Bedeutungszusammenhänge. Die faszinierendsten Funktionen von LLMs umfassen:

Die Evolution von Large Language Models hat das Gesicht der Künstlichen Intelligenz bereits nachhaltig verändert. Mit jedem Fortschritt eröffnen sie aufregende neue Möglichkeiten für die Mensch-Maschine-Interaktion. Sie laden uns ein, die Zukunft mitzugestalten und gemeinsam den Weg in eine Ära fortschrittlicher Technologie zu ebnen.

Unser Fachwissen und unsere Erfahrungen in der KI-Welt bei epicinsights ermöglichen es uns, maßgeschneiderte Lösungen für Ihre Bedürfnisse zu entwickeln, indem wir die Leistungsfähigkeit von Embeddings und LLMs optimal nutzen. Wenn Sie Ihr Unternehmen in die Welt der KI führen möchten, ihre Digitalstrategie entwickeln und ausbauen wollen, sind wir bereit, als Ihr zuverlässiger Partner zur Seite zu stehen. Kontaktieren Sie uns jetzt, um mehr über unsere KI-Kompetenzen und Erfahrungen zu erfahren.

Die Landschaft des Business-Intelligence ist im Wandel – getrieben von den rasch fortschreitenden Entwicklungen im Bereich der künstlichen Intelligenz (KI). Zurecht stellt sich also die Frage: Lohnt sich KI für mich und mein Unternehmen überhaupt? Diejenigen, die bereit sind, in KI-Technologien zu investieren, stehen am Beginn einer Transformationswelle, die maßgeblich über die zukünftige Marktposition entscheidet. Statt im Datendickicht die Sicht zu verlieren, können Sie mit KI-Tools den Durchblick erlangen und echte Wettbewerbsvorteile generieren. Doch wie können KI-Analysen, maschinelles Lernen und automatisierte Datenverarbeitung konkret zu Ihrem Geschäftserfolg beitragen?

Ein Schlüsselbegriff im Kontext der Data-Science ist ‚Machine Learning‘ – ein Subset der KI, das es Maschinen erlaubt, aus Daten zu lernen und Prozesse zu optimieren. Auch Data-Engineers sollten in diesem Kontext nicht unterschätzt werden. KI-gestützte Datenanalysen ermöglichen es Ihnen, Prognosen zu Markttrends abzuleiten oder Kundenverhalten zu antizipieren. Mit diesen Insights setzen Sie auf nachhaltiges Wachstum und eine Effizienzsteigerung, die bisher durch manuelle Analysemethoden unerreichbar blieb.

Die Bedeutung der natürlichen Sprachverarbeitung (NLP) – ein weiterer Fortschritt der KI – kann nicht genug betont werden. NLP erlaubt es, eine neue Dimension der Kundenkommunikation und -interaktion zu entfalten, indem Kundenanfragen automatisiert und intelligent beantwortet werden. Nicht nur für den endkundenzentrierten Bereich bietet KI-Anwendung immenses Potenzial, auch für interne Entscheidungsprozesse liefert sie datenbasierte Handlungsgrundlagen, die Sie der Konkurrenz um Längen voraus sein lassen.

Innovative LLMs (Large Language Models) kommen zunehmend in der Praxis zum Einsatz, um Geschäftsmodelle zu verfeinern und neuzugestalten. Mit der richtigen Anwendung derart fortschrittlicher Modelle steigern Sie nicht nur Ihre Geschäftseffizienz, sondern erschließen auch neue Marktpotenziale. Die Implementierung von Business Intelligence Tools gepaart mit der Automatisierung durch KI-Technologie wird so zum zentralen Dreh- und Angelpunkt erfolgreicher Unternehmen.

In diesem ständig wachsenden Ökosystem der KI-Innovationen ist eine erfahrene KI-Agentur wie Epic Insights unerlässlich, um die Vorteile von KI voll auszuschöpfen. Wir bieten Ihnen datengetriebene Lösungen, die überzeugen – von der Planung Ihrer KI-Strategie über die Implementierung maßgeschneiderter KI-Systeme bis hin zum kontinuierlichen Support. Nutzen Sie unser Expertenwissen, um Ihre Data-Science-Projekte zu verwirklichen und sämtliche Geschäftsprozesse aus einer neuen, datenorientierten Perspektive zu betrachten.

Ob in der Logistikbranche, im Finanzsektor oder im E-Commerce – kein Bereich bleibt von der Digitalen Transformation unberührt. Unternehmen, welche die Zeichen der Zeit erkennen und auf KI-Strategien setzen, werden als Vorreiter aus diesem Wandel hervorgehen.

Mit epicinsights in die KI-Dimension einsteigen bedeutet, sich die Türen zu einer Welt voll neuer Geschäftsmöglichkeiten und Effizienzen zu öffnen. Die Frage „Lohnt sich KI für mich und mein Unternehmen?“ kann somit beantwortet werden.

Warten Sie nicht darauf, dass der Wettbewerb Ihnen zuvorkommt. Werden Sie selbst zum Trendsetter in Ihrer Branche, indem Sie die Kraft künstlicher Intelligenz zu Ihrem Vorteil nutzen. Kontaktieren Sie epicinsights und setzen Sie den ersten Schritt in Richtung einer smarteren und datengesteuerten Zukunft.

Künstliche Intelligenz (KI) hat das Potenzial, Unternehmen in einer Vielzahl von Sektoren zu transformieren. Aber dieser Transformationsprozess ist kein leichtes Unterfangen. Ein zentraler Aspekt der Einführung von KI, der häufig übersehen wird, ist die Säuberung der Daten, die zur Fütterung der intelligenten Modelle verwendet werden. Die Datenbereinigung in KI-Projekten oder auch Data Cleaning genannt stellt viele Unternehmen vor enorme Herausforderungen, da sie grundlegende Änderungen der Unternehmenskultur und der Arbeitsweisen erfordert.

Die Bereinigung der Daten ist ein wesentlicher Schritt in der Vorbereitung von KI-Projekten. Neben allgemeinen Herausforderungen für KI-Projekte im Unternehmen, umfasst der Prozess der Datenbereinigung die Entfernung von Fehlern und Inkonsistenzen in Daten, um ihre Qualität zu verbessern. Doch einfacher gesagt als getan: Die Datenbereinigung ist ein komplexer Prozess, der sowohl technisches Know-how als auch ein tiefes Verständnis des Geschäfts und seiner Datenquellen erfordert.

Eine der größten Herausforderungen in der Datenbereinigung ist die Beseitigung technologischer Schranken. In vielen Unternehmen sind die Daten in verschiedenen Systemen gespeichert und weisen unterschiedliche Formate und Strukturen auf. Dies erschwert die Identifizierung und Korrektur von Fehlern und Inkonsistenzen in den Daten.

Eine weitere Herausforderung besteht darin, eine Unternehmenskultur zu schaffen, die die Bedeutung von Datenqualität und -bereinigung anerkennt. Dies erfordert eine Veränderung in der Denkweise des gesamten Unternehmens – von der Unternehmensführung bis hin zu den Datenanalysten und IT-Teams.

Technologische Hürden sind ein zentrales Problem bei der Datenbereinigung in KI-Projekten. Sie manifestieren sich in verschiedenen Formen, von inkonsistenten Datenformaten bis hin zu veralteten Speichersystemen.

Datenformate und -systeme

Eine der größten Herausforderungen besteht darin, unterschiedliche Datenformate und Speichersysteme zu vereinheitlichen. Dies erfordert die Zusammenführung und Standardisierung von Daten aus vielfältigen Quellen und Formaten.

Technologie zur Überwindung

Moderne Datenintegrationswerkzeuge und Datenmanagementplattformen bieten Lösungen zur Bewältigung dieser Herausforderungen. Sie ermöglichen die effiziente Zusammenführung und Speicherung von Daten, unabhängig von deren ursprünglicher Form.

Architektur und Automatisierung

Eine robuste Datenarchitektur, oft auf Cloud-Plattformen basierend, spielt eine Schlüsselrolle bei der Datenbereinigung. Automatisierung und maschinelles Lernen reduzieren den Aufwand und verbessern die Datenqualität.

Notwendigkeit für den Erfolg

Die Überwindung technologischer Hürden in der Datenbereinigung ist unerlässlich für den Erfolg von KI-Projekten. Durch den gezielten Einsatz von Werkzeugen und Plattformen können Unternehmen ihre Datenqualität sichern und ihre KI-Ziele effektiv erreichen.

Die Verbesserung der Datenbereinigungsprozesse in KI-Projekten erfordert sowohl technologische als auch kulturelle Veränderungen. Technologisch gesehen sollten Unternehmen in Tools und Lösungen investieren, die eine effektive Datenbereinigung ermöglichen. Auf der kulturellen Seite ist die Schaffung einer datengesteuerten Unternehmenskultur entscheidend. Mitarbeiter auf allen Ebenen müssen die Bedeutung von Datenqualität verstehen und den Wert sehen, den eine effektive Datenbereinigung zum Erfolg der KI-Projekte des Unternehmens beiträgt.

Die Datenbereinigung in KI-Projekten stellt zweifellos eine Herausforderung dar. Aber es ist eine Herausforderung, die Unternehmen annehmen müssen, wenn sie das volle Potenzial von KI ausschöpfen wollen. Durch die Verbesserung der Datenbereinigungsprozesse und die Förderung einer datengesteuerten Unternehmenskultur können Unternehmen ihre KI-Projekte sicher und erfolgreich implementieren. Nehmen Sie heute noch die Herausforderung an und beginnen Sie damit, die hohe Qualität Ihrer Daten zur Priorität zu machen.

Bei der Anwendung von Künstlicher Intelligenz (KI) in Unternehmen ist ein Aspekt von entscheidender Bedeutung, der oft übersehen wird: die Qualität der verwendeten Daten. Besonders in der heutigen datengesteuerten Welt kann die Datenqualität den Unterschied zwischen einem erfolgreichen KI-Projekt und einem gescheiterten Experiment ausmachen. Schauen wir uns Daten unter dem Mikroskop an…

Neben beispielsweise unterschiedlichen Consumer-Datentypen, welche die Beziehungen zwischen den Akteuren darstellen (First-, Second- und Third-Party Data), ist jedoch Datenqualität an sich ein komplexer Begriff, der verschiedene Dimensionen umfasst. Dies sind Genauigkeit, Aktualität, Relevanz, Vollständigkeit und Konsistenz. Jede dieser Komponenten spielt eine entscheidende Rolle für die Effektivität von KI-Systemen.

Genauigkeit, Aktualität, Relevanz, Vollständigkeit und Konsistenz sind also die Eckpfeiler guter Datenqualität. Aber was passiert, wenn diese Grundprinzipien ignoriert werden? Schlechte Datenqualität kann zu Fehlinterpretationen führen, die sich negativ auf Unternehmensentscheidungen auswirken. Sie könnte eine ineffektive Ausrichtung von Ressourcen zur Folge haben oder sogar zu einem Verlust des Vertrauens in KI-Initiativen führen.

Wie sagt das Sprichwort? „Shit in, Shit out“. Wenn die Qualität Ihrer Daten mangelhaft ist, können Sie auch von Ihrer KI keine hochwertige Performance erwarten. Eine sorgfältige Überprüfung und Verbesserung der Datenqualität ist daher unerlässlich für den Erfolg Ihrer KI-Initiative. Schließlich kann die Anwendung von KI auf hochwertige Daten dazu beitragen, wertvolle Erkenntnisse zu gewinnen, fundierte Entscheidungen zu treffen und eine effizientere Betriebsführung zu gewährleisten.

Diese Schritte helfen dabei, die Datenqualität hochzuhalten, sodass Sie das Potential Ihrer KI-Projekte voll ausschöpfen können. Erinnern Sie sich daran, dass Datenqualität kein einmaliges Projekt ist, sondern eine ständige Aufgabe, die regelmäßige Pflege und Aufmerksamkeit erfordert.

Was Ihnen jetzt noch fehlt, ist ein Data Quick Check? Sprechen Sie uns gern an! Epicinsights unterstützt Sie mit einem unverbindlichen Check Ihrer Daten. Für mehr Infos rund um das Thema KI und zu den einzelnen Schritten Ihrer Potenzialanalyse stehen wir gern bereit.

Künstliche Intelligenz (KI) entwickelt sich in einem atemberaubenden Tempo. Für Unternehmen, die in diesem Bereich aktiv sind oder planen, in ihn einzusteigen, stellt sich daher zwangsläufig die Frage, wie sie ihre Investitionen und Entwicklungen zukunftssicher gestalten können. Kann man Zukunftssicherheit in der KI-Entwicklung gewährleisten, wenn sich Technologien so schnell ändern?

Sie sollten über folgende These nachdenken: Das Bestreben nach Zukunftssicherheit, in der sich rasch entwickelnden Welt der KI, könnte unrealistisch sein.

Denn angesichts der rasanten technologischen Veränderungen und des hohen Innovationstempos im Bereich der KI ist es schwierig, Entscheidungen zu treffen, die auch in einigen Jahren noch Bestand haben werden.

Das bedeutet jedoch keinesfalls, dass Unternehmen jetzt resignieren und sich dem Lauf der Dinge hingeben sollten. Sie sollten einen flexiblen und adaptiven Ansatz verfolgen, der es ermöglicht, auf Veränderungen zu reagieren. Statt zu versuchen, spezifische Technologieentscheidungen zukunftssicher zu machen, empfiehlt sich ein so genannter Toolbox-Ansatz. Nach diesem Ansatz betreut auch epicinsights erfolgreich Unternehmen. Dieser beinhaltet mehrere KI-Lösungen in Betracht zu ziehen und eine flexible Architektur aufzubauen. Diese kann unterschiedliche Anwendungen und Ansätze integrieren und bietet so die Möglichkeit, die KI-Strategie je nach Bedarf und technologischer Entwicklung anzupassen.

Die Wichtigkeit einer starken Governance und Lenkungsstruktur in der KI-Entwicklung darf dabei nicht vernachlässigt werden. Klare Leitplanken und eine robuste Managementstruktur können sicherstellen, dass KI-Initiativen in die richtige Richtung gehen und Risiken minimiert werden. Es ist eine dynamische und fortwährende Aufgabe, eine solche Architektur zu entwickeln und zu pflegen. Aber eine solche Investition wird auf lange Sicht erhebliche Vorteile bringen.

Letztlich ist die Zukunftssicherheit in der KI-Entwicklung vielleicht weniger eine Frage des richtigen Vorhersagens von Trends und Technologien, sondern vielmehr eine Frage der richtigen Einstellung und Struktur. Mit Flexibilität, Anpassungsfähigkeit und einer starken Governance können Unternehmen sicherstellen, dass sie in der sich schnell verändernden Welt der KI nicht den Anschluss verlieren. Nach den Bedürfnissen des Unternehmens entwickelt epicinsights Individuelle Lösungsansätze. Wir unterstützen als kompetenter Partner für alle Themen rund um Künstliche Intelligenz.

Sollten sie ihre eigenen KI-Modelle entwickeln oder ein fertiges Modell von einem Anbieter kaufen? Viele Unternehmen stehen vor dieser entscheidenden Frage.

Diese Entscheidung ist für KI-Modelle nicht einfach zwischen Schwarz und Weiß zu treffen. Es gibt viele Faktoren, die berücksichtigt werden müssen, bevor man sich für einen Weg entscheidet. Zu diesen zählt die Geschäftsstrategie des Unternehmens, die Risikotoleranz und die entstehenden Kosten. Jedoch auch, inwieweit die vorhandene Datensammlung und die Datenanalyse Methoden des Unternehmens genutzt und in den Dienst der KI gestellt werden kann.

Die „Make or Buy“ Frage gibt es bereits seit langer Zeit im KI-Bereich. Für mächtige Foundation Models wie GPT oder Bard stellt sich die Frage für die meisten Unternehmen nicht wirklich Die Investitionen und Risiken solcher Vorhaben sind für Unternehmen nahezu unlösbar. Ganz zu schweigen von den enormen Datenmengen, die zum Trainieren dieser mächtigen Transformer-Modelle notwendig sind. Setzen wir auf einer abstrakten Ebene an, um uns dem Problem zu nähern.

Als strategischer Begleiter von Unternehmen und KI-Teams haben wir in mehr als 8 Jahren Erfahrungen und relevantes Wissen gesammelt, um Fragen zur „Make or Buy“ Entscheidung zu beantworten. In unserer Beitragsreihe klären wir über die Vor- und Nachteile verschiedener Varianten auf.

Je nach Anwendungsfall gibt es vielerlei Arten von mathematischen Modellen, die Aufgaben des Maschinellen Lernens erfüllen. Von Bilderkennung über Vorhersagen von Zeitreihenbasierten Daten bis hin zu großen Sprachmodellen und NLP (Natural Language Processing). Das Spektrum der Methoden hinter diesen Anwendungsfeldern ist enorm gewachsen.

Entsprechend der konkreten Anforderung bringt die Entwicklung eigener KI-Modelle viele Vorteile mit sich. Unternehmen haben volle Kontrolle über den Entwicklungsprozess und können maßgeschneiderte Lösungen schaffen. Diese sind genau auf ihre spezifischen Bedürfnisse zugeschnitten und in ihre Systemlandschaft integrierbar. Dabei können unternehmenseigene Daten optimal genutzt und in das KI-Modell integriert werden, wobei die Art der Realisierung solcher Projekte exakt auf Compliance Prozesse und Datenschutzanforderungen zugeschnitten werden können.

Auf der anderen Seite stehen jedoch auch Herausforderungen. Der Entwicklungsprozess eines eigenen KI-Modells ist zeitaufwendig und ressourcenintensiv. Insbesondere erfordert die Realisierung, Pflege und Weiterentwicklung der Modelle über die Zeit hinweg fortlaufende Anstrengungen. Diese können nur mit einem festen Team von Fachleuten für maschinelles Lernen und Datenanalyse im Unternehmen oder externen Fachexperten realisiert werden.

Die andere Option, nämlich das Kaufen eines vortrainierten KI-Modells, bringt den Vorteil einer schnellen und einfachen Implementierung mit sich. Moderne Sprachmodelle haben die Tür zu innovativen Technologien, wie z.B. die Analyse von Podcasts, geöffnet.

Zu prüfen gilt hierbei, inwiefern der Anbieter auch die Wartung des Modells übernimmt, da dies dem Unternehmen viel Zeit und Mühe ersparen kann. Der Nachteil liegt jedoch darin, dass weniger Möglichkeiten zur Anpassung vorhanden sind. Vortrainierte Modelle sind oft Allzweck-Lösungen, die auf breitem Wissen aufgebaut sind. Sie sind in der Regel nicht auf die speziellen Anforderungen eines einzelnen Unternehmens zugeschnitten. Unternehmensspezifische oder gar schützenswerte Informationen sind nicht im Modell enthalten. Hier gilt es zu überlegen, inwiefern der Anbieter der Modelle entsprechende Services oder Schnittstellen anbietet, um diese unternehmensspezifischen Daten zu integrieren. Das Unternehmen seinerseits muss sich darüber klar werden, inwiefern es die Kontrolle über die Nutzung und den Schutz seiner Daten aus der Hand geben kann, wenn sich für ein externes, angepasstes Modell entschieden wird.

Die Komplexität des Themas und die individuellen Bedarfe von Unternehmen führen zu keiner eindeutigen Antwort auf die Frage. Eine derart bedeutsame Entscheidung führt oft zu Überlegungen einer Kombination aus beiden Möglichkeiten. Hybridoptionen stellen oft den optimalen Weg dar, da sie die Vorteile beider Welten vereinen. Sie kombinieren die Flexibilität der individuellen Anpassung mit der Geschwindigkeit und Effizienz vorgefertigter Lösungen. Die Herausforderung liegt darin, reibungslos unterschiedliche Systeme und Daten miteinander zu verknüpfen. Big Data Strategien scheinen in diesem Kontext also unerlässlich zu sein, um nicht blind auf willkürliche Ziele zuzusteuern. Hybridansätze ermöglichen es, bewährte KI-Modelle zu nutzen und gleichzeitig maßgeschneiderte Anpassungen über Daten und Workflow-Integrationen einzubringen. Dieser Weg kann je nach Bedarf und Datenlage zwischen Standardlösungen und individuellen Anforderungen ausbalanciert werden.

Jedes Unternehmen sollte eine eigene Strategie bereits vor dem Start in das „Abenteuer KI“ individuell erarbeiten, so dass auf die „Make or Buy“ Frage eine bedarfsgerechte Antwort gefunden wird. Die rein technische Betrachtung von datengesteuerten Lösungen, sowie strategische Fragen rund um das Geschäftsmodell, die Marktentwicklungen, das Personal, die Daten-Infrastruktur und Datensicherheit sowie die zu erwartenden Kosten spielen eine enorme Rolle.

Aber keine Sorge! Kein Unternehmen muss diesen Weg, die Implementierung von künstlicher Intelligenz, allein beschreiten. epicinsights begleitet Unternehmen in jedem Schritt ihrer KI-Initiativen seit 8 Jahren. Durch maßgeschneiderte KI-Workshops adressieren wir individuelle Bedürfnisse von Unternehmen und bauen eine Roadmap zur Beantwortung der „Make or Buy“ Frage auf.

Generative KI, jene künstliche Intelligenz, die in der Lage ist, neue Inhalte zu schaffen, wird zunehmend zum Game-Changer für Unternehmen und deren Digitalisierungsstrategie. Doch welche Markttrends bestimmen aktuell das Feld der generativen KI?

2023 gab es eine klare Bewegung hin zu großen Sprachmodellen, die von führenden Cloud-Anbietern wie OpenAI bzw. Azure, AWS und Google angeboten werden. Diese Modelle können eine nützliche Ressource für Unternehmen sein, die ihre eigenen KI-Lösungen entwickeln wollen. Sie bieten die Grundlage des allgemeinen „Weltwissens“ oder „Sprachwissens“, auf dem Unternehmen aufbauen und ihre eigenen Modelle abstimmen können. Die Nutzung künstlicher Intelligenz kann somit schneller erfolgen, da bereits entwickelte mächtige Sprachmodelle zur Verfügung stehen.

Gleichzeitig wächst die Zahl von Unternehmenssoftwarelösungen, die bereits generative KI-Funktionen eingebettet haben. Das zeigt, dass generative KI nicht mehr nur ein Feld für Forscher und Spezialisten ist, sondern zunehmend auch für den breiten Markt relevant wird. Insbesondere im Bereich der Büroproduktivität gibt es bereits viele große Anbieter, die ihre eigenen generativen KI-Lösungen anbieten. Je nach Anwendung erstrecken sich die „Add-on“-Funktionen der jeweiligen Plattformen z.B. auf die Generierung von Produktdaten (PIM/ DAM), E-Mail-Textgenerierung und Customer Support Konversation (Marketing Automation und CRM-Lösungen), Dokumentation (Notion), Bildgenerierung (Adobe Creative Cloud). Künstliche Intelligenz Agenturen unterstützen Unternehmen dabei, ihre Digitalisierungsstrategien mit KI zu realisieren.

Die Anzahl von Baukasten-Lösungen von Dritten steigt ebenfalls kontinuierlich an. Diese liefern spezifische Anwendungen für generative KI, die nur geringfügige Anpassungen erfordern, um effektiv eingesetzt werden zu können. In der Regel erweitern diese SaaS-Anbieter das Nutzungsspektrum und die Verwaltung von Anwendungsfällen über API-Anbindungen an die oben genannten GenAI-Lösungen von OpenAI, Google und Co. Dabei kann es sich um Lösungen für spezielle Probleme handeln, wie z.B. die Generierung von Bildern in speziellen Formaten oder die automatische Codierung für Websites. Hierbei werden hauptsächlich kleine gestaltbare Workflows und Templates für Prompt-Engineering mit den jeweiligen Use-Cases verknüpft. Erwähnenswert sind hierbei z.B. SaaS-Anbieter auf dem Bereich Low-Code und No-Code für Website-Erstellung, KI-Lösungen für Text-und Bilderzeugung wie Neuroflash oder poe.com. Viele SaaS-Anbieter scheinen jedoch vom Markt zu verschwinden, da ihre Lösungen große Sprachmodelle in lediglich rudimentären Frontend-Lösungen integrieren, ohne eine stabile und eigenständige Entwicklungsgrundlage zu schaffen.

Auch der Markt für Open-Source-Sprachmodelle und Trainingsdaten wächst. Portale wie Hugging Face bieten eine Plattform, auf der Entwickler tausende von offenen KI-Modellen und Datensätzen finden können. Diese sind eine wertvolle Ressource für diejenigen, die bereit sind, ihre eigenen KI-Projekte durchzuführen und dabei von der Arbeit der Community zu profitieren.

Open Source-Modelle bieten die maximale Flexibilität und stellen einen wichtigen Pfeiler für Forschung und Sicherheit bei KI-Entwicklungen dar. Große Plattformen wie Meta und Google bieten ihre Modelle Open Source an, um mit der Community diese sicher und nachhaltig weiterzuentwickeln.

Für Unternehmen stellen Open Source-Lösungen eine optimale Möglichkeit dar, ihr Wissensmanagement, Digitale Workflows und Sprachbasierte Lösungen tief in ihre Prozesse zu integrieren. Bei der Nutzung und Adaption von Open-Source KI-Modellen steht die Verwaltbarkeit der Daten, das Training von Modellen auf spezifische Wissensräume der Unternehmen sowie eine sichere und transparente Integration in die Arbeitsabläufe im Fokus von Projekten. Ebenso sollte frühzeitig über die Verwaltung dieser Modelle, deren Ressourcen-Bedarf sowie die verfügbaren Daten und deren Schutzbedarfe Klarheit geschaffen werden. Ebenso sind intern und extern verfügbare Data Science-Kompetenzen der entscheidende Hebel für die Nutzung von Open Source KI-Modellen.

All diese Trends zeigen, dass das Feld der generativen KI stark in Bewegung ist. Immer mehr Möglichkeiten eröffnen sich – aber auch immer mehr Komplexität entsteht. Die einzige Frage ist, wie man sie am besten für sich einsetzt. Unternehmen sollten evaluieren, wie KI in ihren Betriebsprozess und Geschäftsstrategien genutzt werden kann, sei es im Produktdesign, bei der Verwaltung von Lieferketten oder zur Kundenbindung. Künstliche Intelligenz wird auch zukünftig die Effizienzsteigerungen in KMUs weiter prägen. Eine Big Data Strategieberatung kann vor allem für die potenziellen Kosten eines KI-Projekts sehr hilfreich sein. Letztlich entscheidet der Use-Case über die weiteren Schritte. Wir bei epicinsights sind darauf spezialisiert, KI und Machine Learning Anwendungen individuell in enger Zusammenarbeit für die Bedürfnisse von Unternehmen zu entwickeln und Unternehmen auf dem Weg zur Erschließung von KI-Cases zu begleiten. Wir setzen auf Individualität, um den spezifischen Anforderungen und Zielen von Unternehmen gerecht werden zu können. Sprechen Sie uns gern an!

Künstliche Intelligenz (KI) ist spätestens seit 2023 ein Muss für digital ausgerichtete Unternehmen. Eine besondere Art von KI, die generative KI, kann ein Business auf ein ganz neues Level heben. Generative KI bezieht sich auf KI-Systeme, die neue Inhalte oder Daten erstellen können. Beispiele dafür sind Generative Adversarial Networks (GANs), die realistische Bilder erzeugen können, und Large Language Models (LLMs) wie GPT-4, die menschenähnlichen Text generieren können. Bei epicinsights sind wir darauf spezialisiert, KI und Machine Learning Anwendungen individuell für die Bedürfnisse von Unternehmen zu entwickeln. Ab sofort gehört generative KI ebenfalls zu unserem Portfolio. Dank individuell trainierter Large Language Models können wir generative KI zum Herzstück Ihres Unternehmens machen – ganz ohne ChatGPT & Co. Die von uns verwendeten LLMs werden sicher und datenschutzkonform in Deutschland gehostet, mit Domänenwissen Ihrer Branche trainiert und individuell auf ihr Unternehmen adaptiert.

Wir wissen, dass Sicherheit und Datenschutz bei der Nutzung von KI eine große Rolle spielen. Daher liegt hier auch unser Augenmerk. Ihre generativen KI-Modelle sind bei uns in guten Händen, denn wir hosten sie sicher auf deutschen Servern. Und weil wir wissen, dass Sie die Kontrolle über Ihre Daten behalten möchten, bieten wir eine On-Premise-Lösung sowie individuelle Rechte – und Rollensysteme für den Informationszugriff. So bestimmen Sie, wer was sehen darf. Sie haben die Kontrolle!

Sie sind der Experte / die Expertin in Ihrem Business Bereich, wir sind die KI Experten. Lassen Sie uns Hand in Hand arbeiten, um individuell trainierte Large Language Models (LLMs) zu entwickeln, die genau auf Ihre Bedürfnisse zugeschnitten sind. Diese personalisierten KI-Assistenten helfen dabei, Ihr Business noch effizienter zu machen.

Generative KI hat eine Menge zu bieten:

Entdecken Sie die Kraft der generativen KI mit unserer revolutionären Wissensmanagement-Lösung! Kein mühsames Durchsuchen von Dokumenten mehr, kein Rätselraten – nur klare, präzise Antworten, wann immer Sie sie brauchen. Mit Lösungen von epicinsights gestaltet sich Ihr Business Alltag effizienter, Sie können Kosten sparen und Kunden glücklicher machen. Also worauf warten Sie?

Dann nehmen Sie Kontakt mit uns auf, um herauszufinden, wie generative KI in Ihrem Unternehmen genutzt werden kann!

Unverbindlich Beraten lassen